Nhu cầu con người ngày càng tăng đối với các dịch vụ AI như nhận dạng hình ảnh và giọng nói, xử lý ngôn ngữ tự nhiên, tìm kiếm trực quan và đề xuất được cá nhân hóa. Với việc các bộ dữ liệu đang phát triển, các mạng ngày càng phức tạp hơn thì yêu cầu về độ trễ ngày càng thắt chặt để đáp ứng mong đợi của người dùng. Một sản phẩm tốt cần đáp ứng được cả độ chính xác cao và thời gian xử lý thấp. Open VINO và TensorRT được xây dựng để hỗ trợ các mô hình đáp ứng nhu cầu này.

Việc cải thiện hiệu quả của những mô hình sẽ có ảnh hưởng lớn đến hiệu suất đối với người dùng thông thường. Mô hình có độ chính xác rất cao sẽ kéo theo yêu cầu về thời gian xử lý dài và ngược lại, các mô hình có tốc độ xử lý nhanh có thể dẫn đến độ chính xác bị giảm đáng kể.

Do đó, trong suốt quá trình xây dựng và hoàn thiện một sản phẩm có ứng dụng machine learning hoặc deep learning bên trong đó, ngoài việc mô hình hoá thuật toán, các công đoạn liên quan đến kỹ thuật (engineering) hoặc triển khai (deployment) cũng đóng vai trò hết sức quan trọng để hoàn thiện sản phẩm. Có thể kể tới 1 số tác vụ như: kỹ thuật nén mô hình (mô hình compression), cắt tỉa mạng nơ-ron (mô hình pruning), kết hợp các trọng số theo cụm để biểu diễn các liên kết (mô hình quantization),.. để cắt tỉa, lượng tử hóa mô hình khiến mô hình nhẹ hơn, giảm thiểu thời gian suy luận mà độ chính xác của mô hình không đổi hoặc sai khác không đáng kể.

Với nhu cầu thực tế về việc tối ưu hoá mô hình, độ chính xác đủ cao và tốc độ xử lý đủ chấp nhận, hai ông lớn Intel và NVIDIA đã cho ra đời 2 nền tảng áp dụng vào quá trình tối ưu tốc độ xử lý của mô hình là OpenVINO và TensorRT.

OpenVINO

Tên viết tắt của Open Visual Inference and Neural Network Optimization. OpenVINO toolkit được xây dựng và phát triển bởi Intel, được tạo ra nhằm mục đích tối ưu hóa hiệu năng của mô hình trên chính các bộ vi xử lý của Intel, cải thiện thời gian suy luận khi tiến hành triển khai mô hình trên rất nhiều các nền tảng khác nhau (CPU / GPU / VPU / FPGA). Đây là nền tảng hỗ trợ các mô hình lập trình phổ biến và các thư viện cơ bản biến mã cấp cao thành các hướng dẫn tối ưu hoá cho các nền tảng phần cứng cụ thể bao gồm CPU, GPU, VPU Movidius.

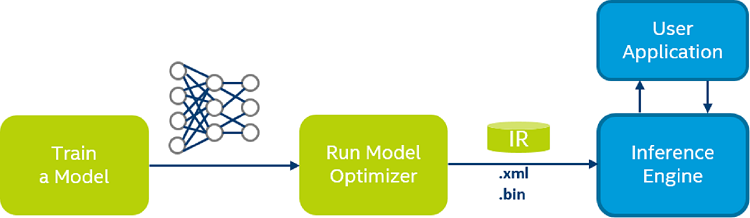

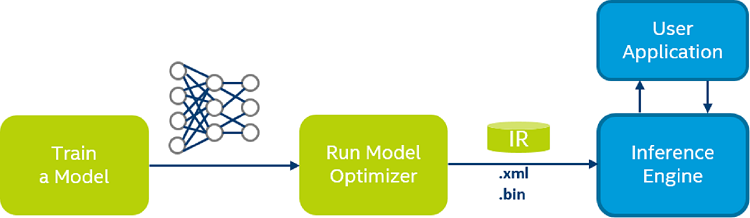

Các yếu tố chính của bộ công cụ OpenVINO bao gồm:

- Trình tối ưu hoá Mô hình,

- Công cụ suy luận và

- Vườn thú Mô hình Mở.

Ưu điểm của bộ công cụ:

- Cho phép suy luận học sâu dựa trên CNN

- Hỗ trợ thực thi không đồng nhất trên CPU Intel®, Đồ họa tích hợp Intel®, Intel® FPGA, Intel® Neural Compute Stick 2 và Intel® Vision Accelerator Design với VPU Intel® Movidius ™

- Tăng tốc thời gian đưa ra thị trường thông qua thư viện dễ sử dụng các chức năng thị giác máy tính và hạt nhân được tối ưu hóa trước

- Bao gồm các lệnh gọi được tối ưu hóa cho các tiêu chuẩn thị giác máy tính, bao gồm OpenCV và OpenCL ™.

OpenVINO được phát triển với mục đích hướng tới cải thiện khả năng suy luận của mô hình, đặc biệt liên quan tới các bài toán về thị giác máy tính như: phân loại hình ảnh (Image Classification), phát hiện vật thể (Object Detection), theo dõi vật thể (Object Tracking).

Hình 1: Luồng suy luận cơ bản (Chuyển đổi các mô hình đã huấn luyện trước sang định dạng IR hay Intermediated Representation của OpenVINO)

Tensor RT

Là 1 toolkit hỗ trợ cải thiện năng suất và thời gian suy luận của mô hình, hỗ trợ rất tốt trên GPU. Nền tảng suy luận của NVIDIA mang lại hiệu suất, hiệu quả và khả năng đáp ứng rất quan trọng để cung cấp năng lượng cho thế hệ tiếp theo của các sản phẩm và dịch vụ AI trên đám mây, trong trung tâm dữ liệu, ở rìa mạng và trên xe.

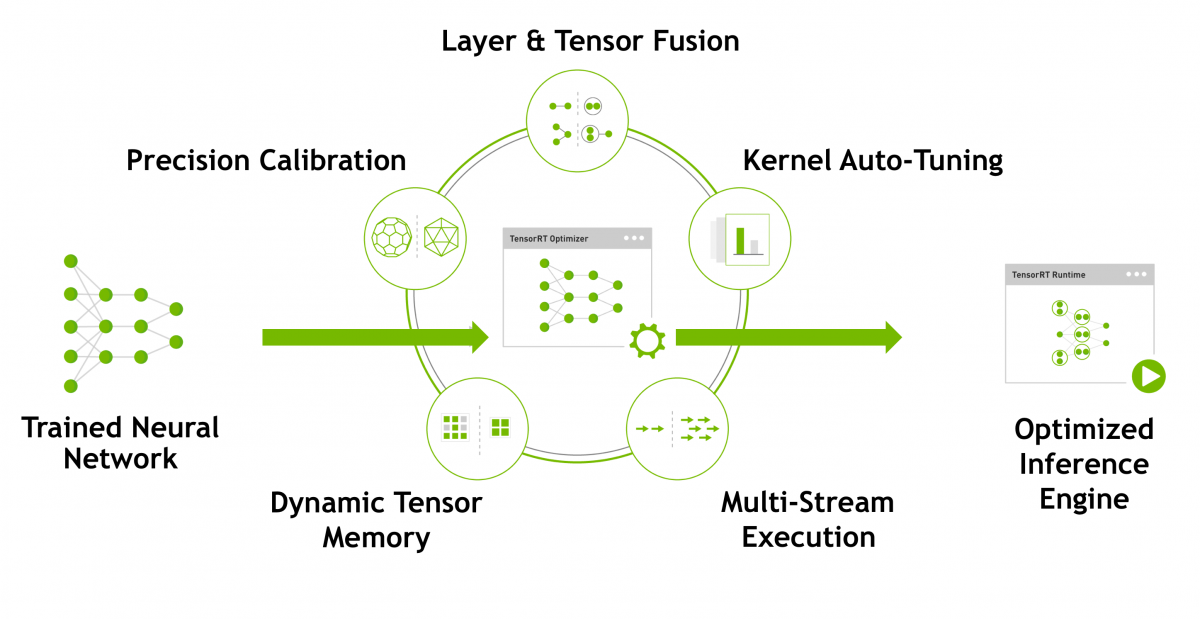

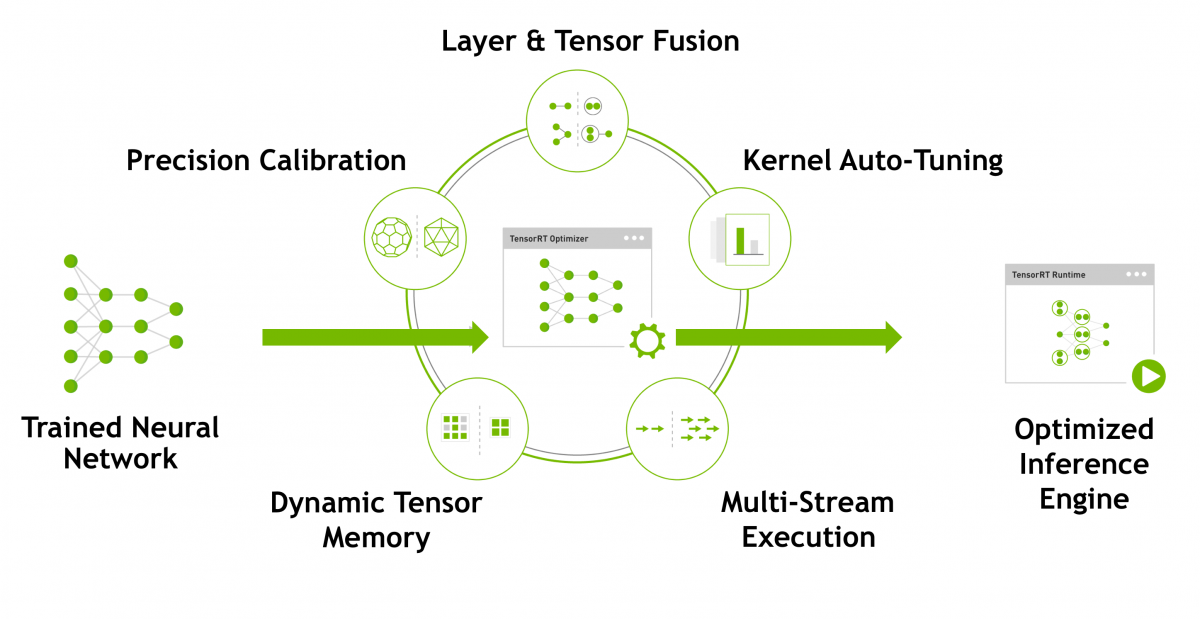

Hình 2: Tensor RT tối ưu các mô hình mạng nơ-ron đã được huấn luyện để tạo ra những cơ chế suy luận thời gian sẵn sàng triển khai.

Giải phóng tiềm năng đầy đủ của GPU NVIDIA với NVIDIA TensorRT

TensorRT là chìa khóa để mở khóa hiệu suất suy luận tối ưu. Sử dụng NVIDIA TensorRT, có thể nhanh chóng tối ưu hóa, xác thực và triển khai các mạng thần kinh được đào tạo để suy luận. TensorRT cung cấp thông lượng cao hơn tới 40 lần trong độ trễ thời gian thực khi so sánh với suy luận chỉ CPU.

Hợp nhất, từ đầu đến cuối, suy luận học tập sâu có thể mở rộng

Với một kiến trúc hợp nhất, các mạng thần kinh trên mọi khung học sâu có thể được đào tạo, tối ưu hóa với NVIDIA TensorRT , và sau đó được triển khai để thảo luận theo thời gian thực ở rìa. Với các hệ thống NVIDIA DGX™ , NVIDIA Tesla® , NVIDIA Jetson ™ và NVIDIA DRIVE™ PX , NVIDIA cung cấp một nền tảng học tập sâu, có thể mở rộng hoàn toàn, có thể mở rộng.

Tiết kiệm chi phí ở quy mô lớn

Để giữ cho máy chủ đạt năng suất tối đa, các nhà quản lý trung tâm dữ liệu phải đánh đổi giữa hiệu suất và hiệu quả. Một máy chủ NVIDIA Tesla P4 có thể thay thế mười một máy chủ CPU hàng hóa để học sâu các ứng dụng và dịch vụ suy luận, giảm yêu cầu năng lượng và tiết kiệm chi phí tới 80%.

Trí thông minh nhân tạo, học máy và học sâu đã cho thấy triển vọng từ nhiều thập niên trước nhưng chỉ vài năm trở lại đây và thậm chí là vài tháng quá, chúng ta mới bắt đầu thật sự nhìn thấy chúng bước ra khỏi những phòng lab. Vẫn còn một khối lượng lớn công việc cần thực hiện bởi các hãng công nghệ như NVIDIA hay INTEL nhưng những công cụ hỗ trợ hiện tại đã cho thấy AI có tiềm năng thực sự và có thể hỗ trợ con người một cách nhanh chóng và hoàn hảo hơn.